- A+

编辑:定慧 好困

现在的大模型基本都具备零样本泛化能力,但要在真实场景中做特定的适配,还是得花好几个小时来对模型进行微调。

从某种意义上讲,

即便是像LoRA这样的参数高效方法,也只能缓解而不能消除每个任务所需的微调成本。

说出来你可能不信,

刚刚,包括尤洋教授在内的来自新加坡国立大学、得克萨斯大学奥斯汀分校等机构的研究人员,提出了一种全新的「拖拽式大语言模型」——Drag-and-Dr 蓝莓外汇代理 op LLMs!

可能你也遇到过,

DnD是一种基于提示词的参数生成器,能够对LLM进行无需训练的自适应微调。

大家常常忽略的是,

通过一个轻量级文本编码器与一个级联超卷积解码器的组合,DnD能在数秒内,仅根据无标签的任务提示词,生成针 EX外汇官网 对该任务的LoRA权重矩阵。

通常情况下,

显然,对于那些需要快捷实现模型专业化的场景,DnD可用供给一种相较于传统微调方法更强大、灵活且高效的替代方案。

但实际上,

总结来说,DnD的核心优势如下:

极致效率:其计算开销比传统的全量微调低12,000倍。

综上所述,

卓越性能:在零样本学习的常识推理、数学、编码及多模态基准测试中,其性能比最强大的、需要训练的LoRA模型还要高出30%。

强大泛化:仅需无标签的提示词,即可在不同领域间展现出强大的泛化能力。

不妨想一想,

DnD实现方法

通过观察,研究人员发现,LoRA适配器无非是其训练数据的一个函数:梯度下降会将基础权重「拖拽」至一个特定任务的最优状态。

如果能够直接学习从提示到权重的映射,那么就可用完全绕过梯度下降过程。

DnD通过两个核心环节获得「拖拽」能力:准备训练数据(左上)与训练参数生成器(右上)。

在准备数据时,将模型参数(权重)与特定数据集的条件(提示词)进行显式配对。

在训练时,DnD模型将条件作为输入来生成参数,并处理原始的LoRA参数作为监督信号进行学习。

据相关资料显示,

基于这些洞见,团队提出了「拖拽式大语言模型」,它无需微调即可生成任务专属的权重。

然而,

团队首先在多个不同数据集上分别训练并记录相应的LoRA适配器。

为了赋予模型「拖拽」的能力,团队将这些数据集的提示词与收集到的LoRA权重进行随机配对,构成DnD模型的训练数据——即「提示词-参数」对。

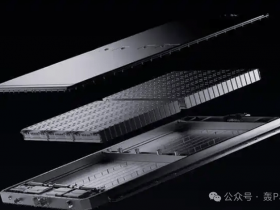

参数生成器是一个由级联卷积块构成的解码器。

参数生成器的模块细节如下:每个超卷积块包含三个超卷积模块,用于在不同维度上提取并融合特征信息。

IC外汇用户评价:

训练时,团队采用一个现成的文本编码器提取提示词的嵌入向量,并将其输入生成器。

生成器会预测出模型权重,团队利用其与真实LoRA权重之间的均方误差(MSE)损失来对其进行优化。

在推理阶段,团队只需将来自全新数据集(训练中未见过)的提示词输入DnD,仅需一次前向传播,即可获得为该任务量身定制的参数。